- English

- 日本語

robots.txt ファイルの作成とカスタマイズ

最終更新日 2018-08-16

robots.txt ファイルは、Webサイト上の Web ページをクロールする方法を Web ロボットに指示するために使用します。Fastly のコントロールパネルを使用して robots.txt ファイルを作成および設定することができます。このガイドの指示に従うことで、Fastly はキャッシュから robots.txt ファイルを提供するようになるため、リクエストはオリジンをヒットしません。

robots.txt ファイルの作成

robots.txt ファイルを作成・設定するには、以下の手順に従ってください。

- Fastly コントロールパネルにログインします。

- Home ページから、適切なサービスを選択します。検索ボックスで ID、名称、ドメインによる検索が行えます。

- Edit configuration をクリックし、アクティブなバージョンをクローンするオプションを選択します。

- Content をクリックします。

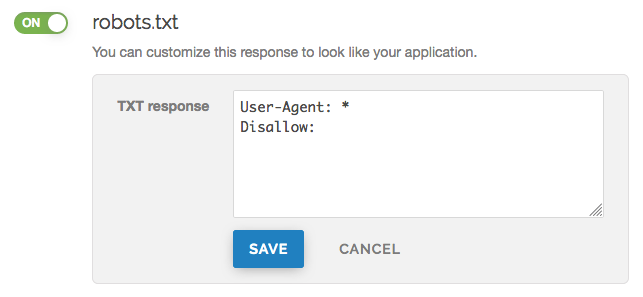

robots.txt スイッチをクリックして robots.txt のレスポンスを有効にします。

TXT Response フィールドで、robots.txt ファイルのレスポンスをカスタマイズします。

Save をクリックしてレスポンスを保存します。

- Activate をクリックして設定への変更をデプロイします。

手動で robots.txt ファイルを作成・カスタマイズする

robots.txt のレスポンスをカスタマイズする必要がある場合は、以下の手順に従って手動でシンセティックレスポンスと条件を作成することができます。

- Fastly コントロールパネルにログインします。

- Home ページから、適切なサービスを選択します。検索ボックスで ID、名称、ドメインによる検索が行えます。

- Edit configuration をクリックし、アクティブなバージョンをクローンするオプションを選択します。

- Content をクリックします。

Set up advanced response をクリックします。

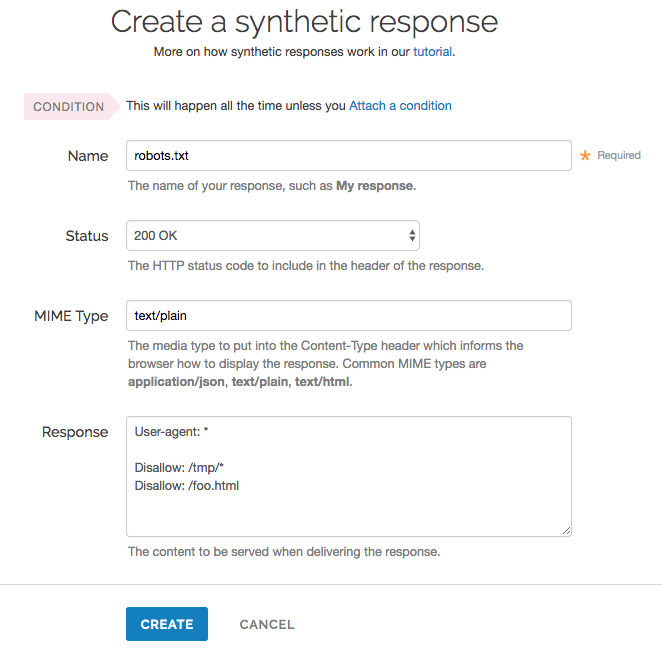

以下の要領で Create a synthetic response ページの各フィールドに入力します。

- Name フィールドに適切な名前を入力します。例:

robots.txt。 - Status メニューは変更せずにデフォルトの

200 OKにしておきます。 - MIME Type フィールドに

text/plainと入力します。 - Response フィールドに、User-agent 文字列と Disallow 文字列を少なくとも1つ入力します。上の例では、すべてのユーザーエージェントに (文字列によって)、

User-agent: *ディレクトリや/tmp/ファイル (それぞれ/foo.htmlとDisallow: /tmp/*``Disallow: /foo.html文字列によって) 配下のクロールを許可しないように指示しています。

- Name フィールドに適切な名前を入力します。例:

Create をクリックします。

新たに作成されたレスポンスの右側にある Attach a condition リンクをクリックします。

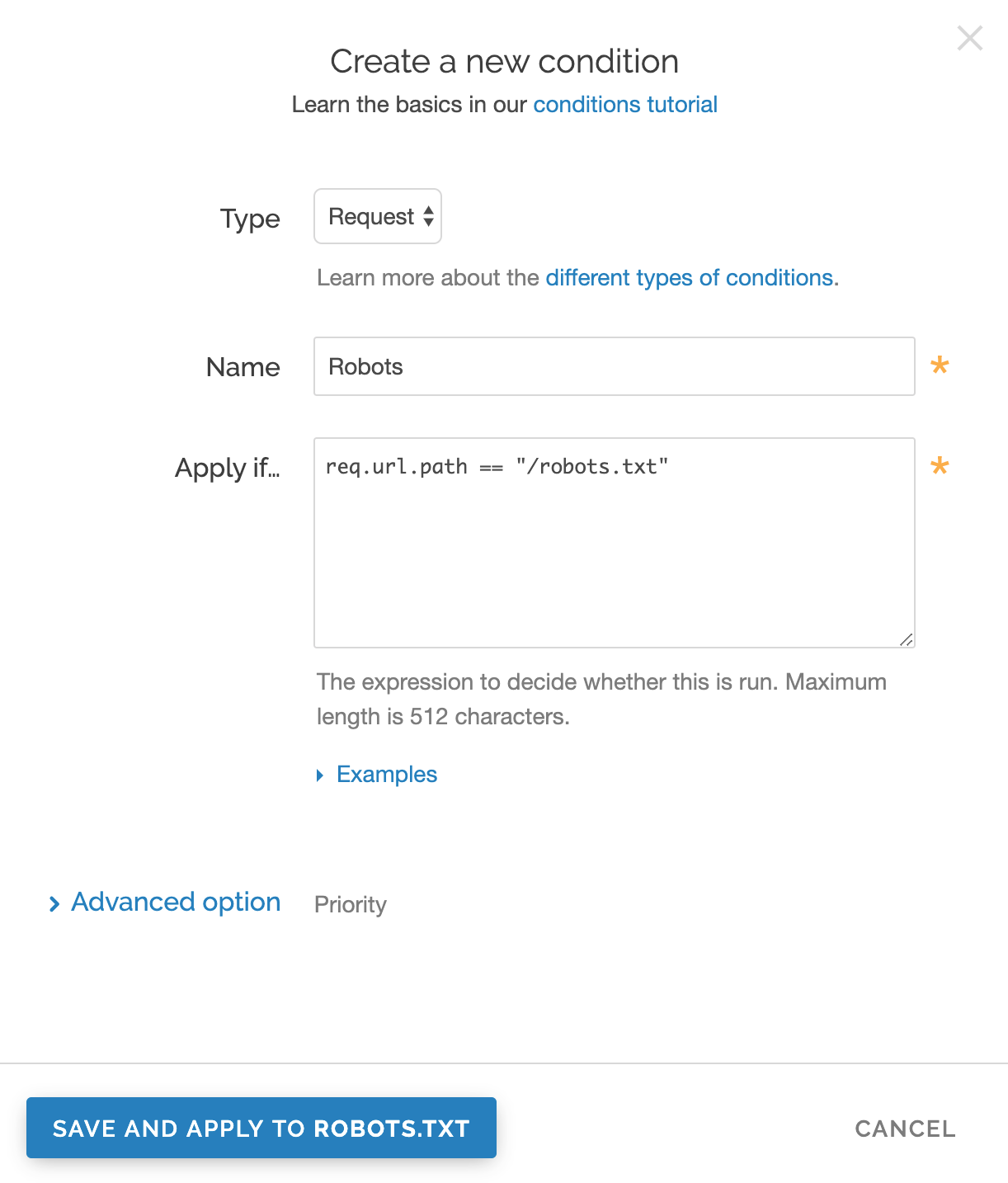

以下の要領で Create a condition ページの各フィールドに入力します。

- Type メニューから、適用したい条件を選択します (例:

Request)。 - Name フィールドに、条件を説明する名前を入力します (例:

Robots)。 - Apply if フィールドに、条件が true か false かを判断するために VCL 内で実行する論理式を入力します。この場合、論理式は robots.txt ファイルの場所になります (例:

req.url.path == "/robots.txt")。

- Type メニューから、適用したい条件を選択します (例:

Save をクリックします。

- Activate をクリックして設定への変更をデプロイします。

注意

カスタムレスポンスの作成方法の詳細については、レスポンスのチュートリアルをご覧ください。

global.prod.fastly.net で robots.txt ファイルをカスタマイズできない理由

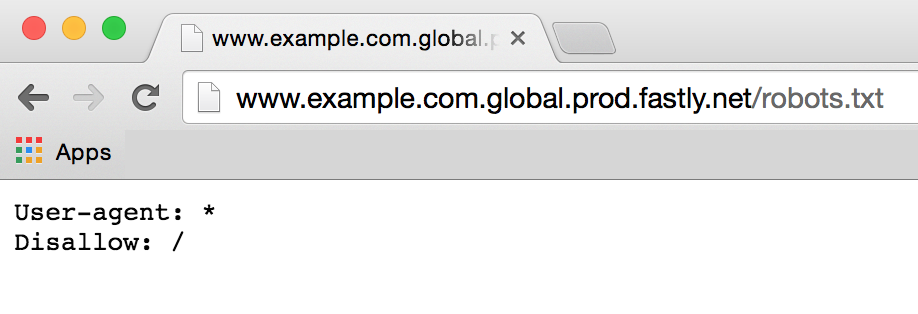

ブラウザや curl コマンドでドメインに .global.prod.fastly.net 拡張子を追加すると (例: www.example.com.global.prod.fastly.net)、Fastly のサービスを使って本番サイトがどのように動作するかをテストすることができます。

Google が誤ってこのテスト URL をクロールするのを防ぐために、Fastly は内部 robots.txt ファイルを用意しました。このファイルは Google の Web クローラーが .prod.fastly.net で終わるホスト名の全ページを無視するように指示します。

この内部の robots.txt ファイルは、ドメインの CNAME DNS レコードが global.prod.fastly.net を指すように設定されるまで、Fastly のコントロールパネルでカスタマイズすることはできません。

翻訳についての注意事項

このフォームを使用して機密性の高い情報を送信しないでください。サポートが必要な場合は、サポートチームまでご連絡ください。このフォームは reCAPTCHA によって保護されており、Google のプライバシーポリシーと利用規約が適用されます。